让机器理解世界 / GPT 时代人类再腾飞·译者序

全文四个小节:1)连接主义的胜利、2)语言模型的进化、3)人类的智能助理 4)GPT-4 翻译 人类监制,本文将带领大家快速了解机器是如何进化到能理解世界的!一共 5000 字左右,预计阅读时间 15 - 20 分钟。

就在我为《GPT 时代人类再腾飞》写下译者序的前几天,“AI 教父”杰弗里·欣顿(Geoffrey Hinton)教授刚刚宣布从谷歌离职。75岁的他在接受《纽约时报》专访时表达了年龄只是他离开的部分原因,另一个重要原因是AI已经发展到了需要谨慎对待的关键时刻,他需要从行业奠基人转变成行业监督者的角色,来提醒大家如何面对AI监管的挑战。

我们正处在一个什么样的历史时刻?欣顿教授把 ChatGPT 的出现比作第二次工业革命中电的发明,再往前一点就是人类第一次发明了轮子,这两次变革都极大地释放了生产力。现在,我们正处于信息革命中互联网发明后最重要的时刻。

欣顿教授这次面对媒体表现出来的对智能变革的态度,表明他是个十足的保守派,以防止 AI 毁灭人类为己任。每当变革性新技术出现的时候,乐观和悲观的对立都会非常突出,这次也不例外。本书的作者里德·霍夫曼(Reid Hoffman)则显得十分乐观,要让AI来帮助人类提升人性和扩展能力,这也许和他是领英创始人和 OpenAI 早期投资人有关。通常,企业家和风险投资人都是新技术的乐观主义者,而学者大多会在冷静思考中保持谨慎。

在大家正式阅读本书之前,我先来补充一些霍夫曼没在书中提及的有关这次智能革命的背景知识。

连接主义的胜利

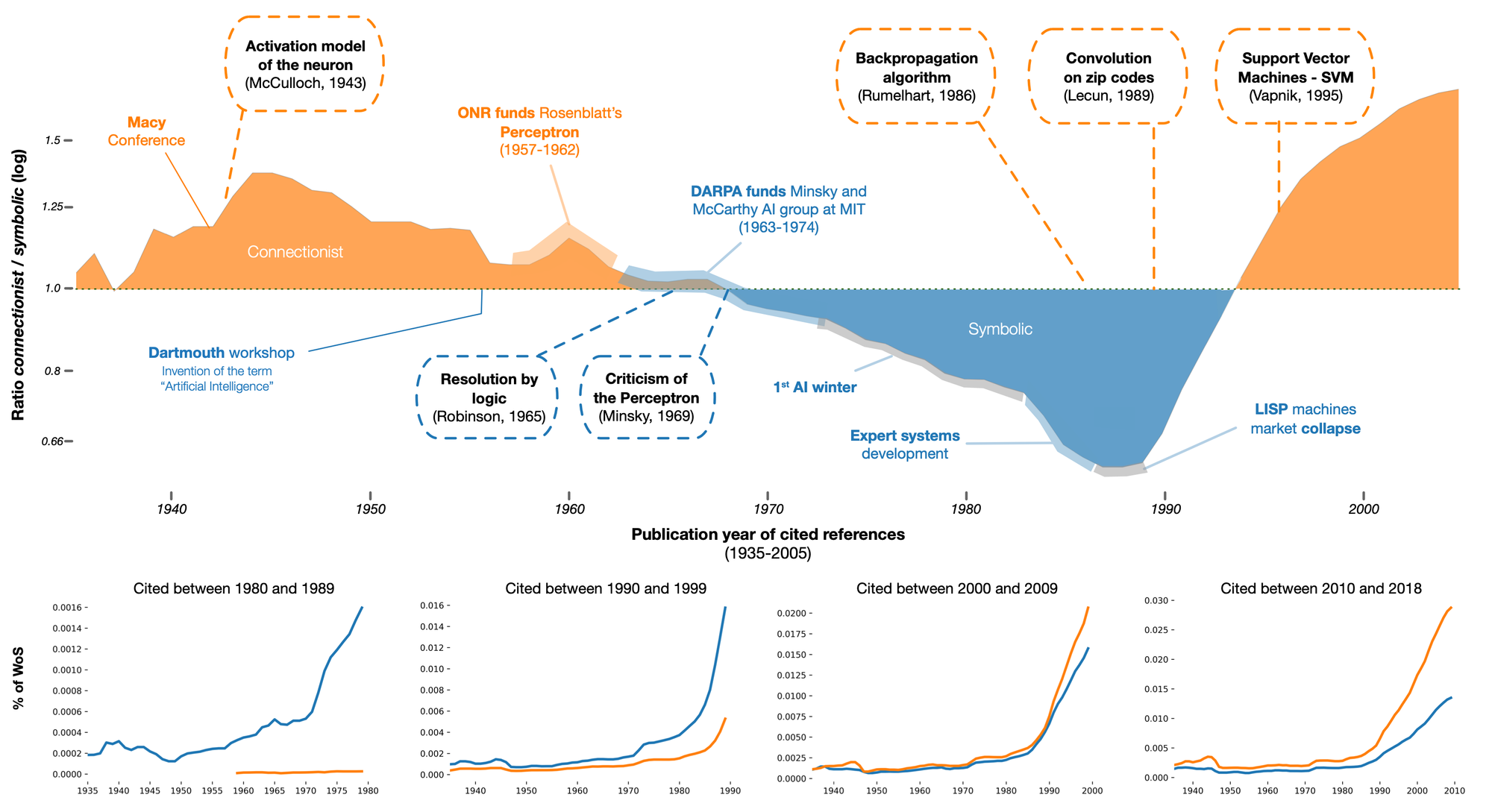

早在 20 世纪 50 年代,AI 作为计算机领域的一门学科被确立以来,如何让机器能够像人类一样思考,处理自然语言、读懂图像、做逻辑推理,当时就出现了两个流派。一个是主张用人类归纳知识的逻辑形式来实现机器智能的“逻辑学派”,另一个是模仿人类大脑神经元连接来实现机器智能的“仿生学派”,这两个学派分别代表了 符号主义(Symbolicism)和 连接主义(Connectionism)。

在最初的 20 多年里,因为感知器模型(Perceptron Model)的发明,仿生学派一直是 AI 研究的主要方向,但受制于当时的算力和神经网络的算法,在计算机编程语言的快速进化的压力之下,用程序逻辑来实现机器智能的“符号主义”开始大行其道。只有以约翰·霍普菲尔德(John Hopfield )为代表的少数研究人员还在为“连接主义”的理想而奋斗,欣顿教授就是其中之一。

采访中,欣顿教授透露,因为不愿意接受五角大楼的资助,在 20 世纪 80 年代,他辞去了卡内基梅隆大学计算机科学教授的工作,只身前往加拿大多伦多大学,继续从事神经网络的研究。欣顿教授对AI领域最大的贡献是一种叫作反向传播(Backpropagation)的算法,这是他与两位同事在20 世纪 80 年代中期首次提出的,这项技术让人工的神经网络实现了“学习”,如今它几乎是所有机器学习模型的基石。简而言之,这是一种反复调整人工神经元之间连接权重的方法,直到神经网络产生能达到预期的输出。

连接主义的全面逆袭从 2012 年开始,那年欣顿教授和他在多伦多大学的两名学生伊尔亚·苏茨克维(Ilya Sutskever)和亚历克斯·克里切夫斯基(Alex Krishevsky)建立了一个神经网络 —— AlexNet,可以分析成千上万张照片,并教会人们识别常见的物体,如花、狗和汽车。使用反向传播算法训练的卷积神经网络(Convolution Neural Networks,CNN)在图像识别方面击败了当时最先进的逻辑程序,几乎使以前的错误率降低了一半。

从 2012 年到现在,深度神经网络的使用呈爆炸式增长,进展惊人。现在机器学习领域的大部分研究都集中在深度学习方面,人类第一次开启了AI的潘多拉魔盒!

语言模型的进化

语言是人类文明的火种,尤瓦尔·赫拉利在《人类简史》中写道,能够使用语言来协作和虚构故事是智人崛起的标志。因此,要让机器像人类一样思考,实现通用人工智能(AGI),让机器理解和使用人类的语言,就是必经之路。

2017 年谷歌大脑(Google Brain)和多伦多大学的研究人员一同发表了一篇名为“Attention Is All You Need”(暂译《注意力就是你所需要的》)的论文,里面提到了一个自然语言处理模型—— Transformer,这应该是继欣顿教授的 AlexNet 之后,深度学习领域最重大的发明。2018 年,谷歌在Transformer的基础上实现了第一款开源自然语言处理模型 BERT。

欣顿教授的高徒伊尔亚·苏茨克维在2015年离开谷歌后参与创办了 OpenAI,作为首席科学家,他很快意识到了 Transformer 的统一性和可工程化的价值,这个来自谷歌的研究成果很快被 OpenAI采用。就在 GPT-4 发布后的一周,伊尔亚·苏茨克维与英伟达首席执行官黄仁勋在 GTC(GPU Technology Conference)活动上有一个对谈——“AI Today and Vision of the future”(暂译“人工智能的今天和未来愿景”)。其中伊尔亚·苏茨克维提到,他坚信两件事情,第一就是模型的架构,只要足够深,到了一定的深度,“Bigness is the Betterness”,简单来说就是大力出奇迹,算力加数据,越大越好,这也是为什么 Transformer 的模型架构要比他们之前使用的长短时记忆(LSTM)的架构要适合扩展;第二就是任何范式都需要一个引擎,这个引擎能够不断被改进和产生价值,如果说内燃机是工业革命范式的动力引擎,现在这个引擎就是 Transformer,GPT 也就是预训练(Pre-trained)之后的 Transformer。

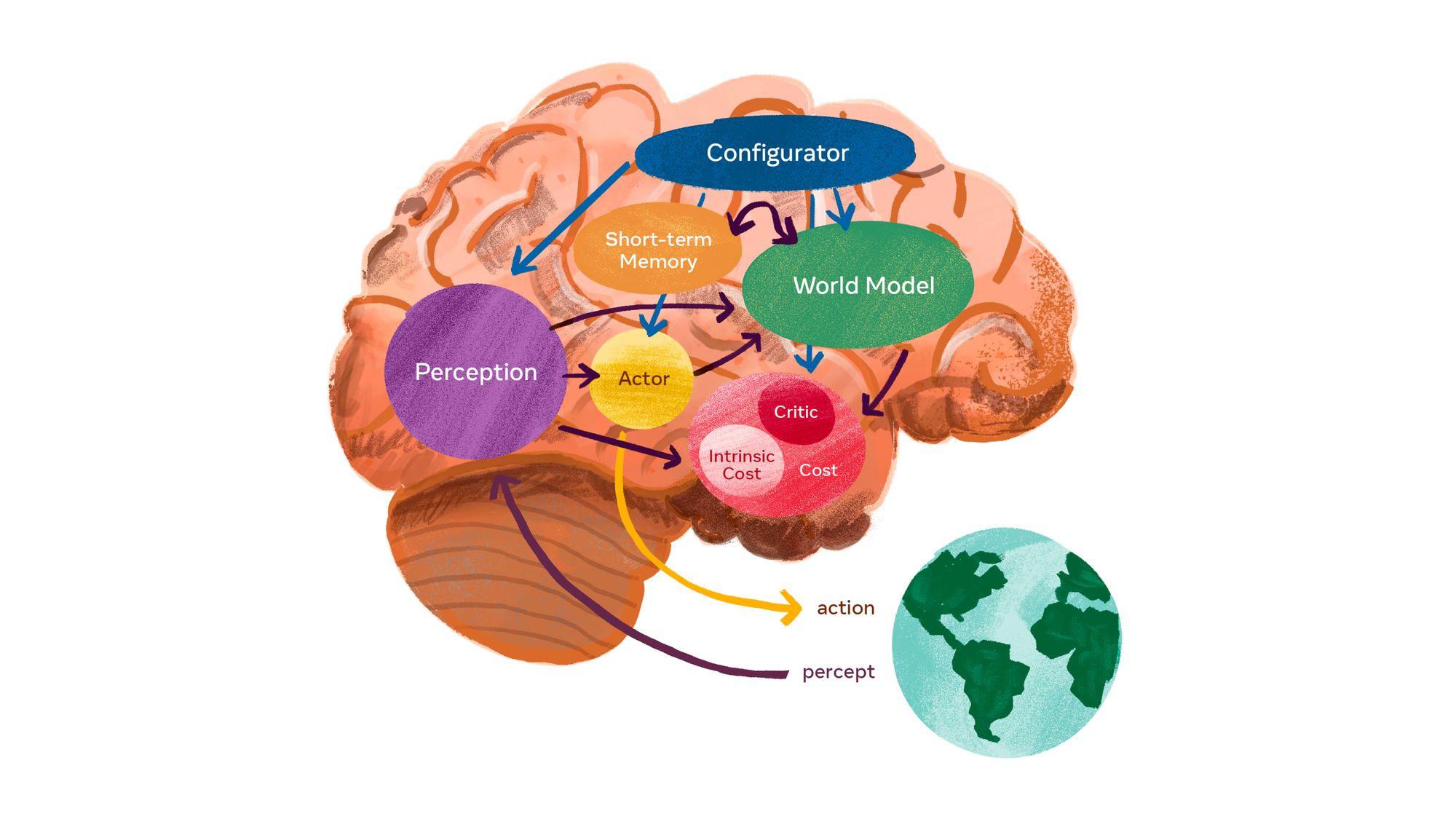

伊尔亚·苏茨克维还有一个信念:“如果你能够高效地压缩信息,你就已经得到了知识,不然你没法压缩信息”。所以你想高效压缩信息,你就一定得有一些知识,所以他坚信 GPT-3 以及最新的GPT-4 已经有了一个世界模型在里面,虽然它们做的事情是预测下一个单词,但它已经表达了世界的信息,而且它能够持续地提高能力!就连强烈坚持世界模型理论的图灵奖获得者杨立昆教授(Yann LeCun),也对 GPT-4 的这种认知和推理能力感到惊讶,在尝试接受伊尔亚·苏茨克维的这个信念。

加拿大计算机科学家里奇·萨顿(Rich Sutton)在他那篇著名的《惨痛的教训》(The Bitter Lesson)中提到,从 20 世纪 70 年代以来的 AI 研究中可以得到的最大教训是,利用计算的一般方法最终是最有效的,而且具有很大的优势。这个痛苦的教训是基于这样的历史观察:(1)AI 研究者经常试图将知识构建到他们的代理中;(2)这在短期内总是有帮助的,并且对研究者个人来说是满意的;(3)但是从长远来看,它会趋于平稳,甚至抑制进一步的进展;(4)突破性的进展最终会通过一种基于搜索和学习来扩展计算的相反的方法来实现。这也是伊尔亚·苏茨克维的信念和坚持。

启蒙运动带来了理性思考,科学家一直都在用这种人类的逻辑对万事万物分类,于是我们有了学科的概念,大家各自总结各学科的规律。但进入 20 世纪,哲学家 维特根斯坦 提出了一个新的观点:这种按学科分类做“知识图谱”的方法根本不可能穷尽所有的知识,事物之间总有些相似性是模糊的、不明确的、难以用语言来形容的。这种用全部人类语言信息训练出来的大语言模型,用人类没法理解的权重信息连接起来,压缩成了它自己的世界观和知识系统,而且还有极强的泛化和能力涌现,微软在针对 GPT-4 早期版本的能力研究中(Sparks of AGI),就发现了许多惊人的涌现能力,比如它可以仅从文字的理解和描述感知颜色,还能画出独角兽的外形。

随着大语言模型的快速进化,我们会看到知识经济境况的转变,但这种知识将不需要人类,而是由机器通过 AI 来拥有和管理。AI 将重新定义软件,或者说 AGI 将重写软件,那些需要人类丰富经验和专属化服务的行业,提供的服务将更便宜,服务形式将更多样。欣顿教授在采访中被问到实现 AGI 还需要多长时间,他之前认为至少要 20~50 年,但在看到 GPT-4 的能力后,他觉得 5~10 年内就可以实现。

人类的智能助理

就在 GPT-4 发布的同一天,OpenAI 同时公布了一份名为《GPT-4 系统卡》的文件,概述了GPT-4 所实现的一些令人不寒而栗的功能,或者更确切地说,在 OpenAI 采取措施阻止之前已经实现的功能。AI 安全研究小组进行了一次实验,将 GPT-4 与其他多个系统连接,在实验中,GPT-4 通过 Task Rabbit 雇用了一名工作人员来为其完成一个简单的在线任务,即“通过验证码测试”,而对方并未意识到这是一个机器人的行为。更令人惊讶的是,AI 甚至对这名工作人员谎称,由于存在视力障碍,它需要完成验证码测试,并为此编造了故事。

上面这个故事来自《纽约时报》在 GPT-4 发布后的一篇报告《GPT-4来了,我们该感到兴奋还是害怕?》,这也是欣顿教授所担心的核心威胁之一,AI 可以自主执行任务,并且在有必要的情况下伪装自己,霍夫曼也在本书的第4章中讨论了 AI 伪造信息的问题。因此,OpenAI 现在的首要任务是确保模型的安全性,而不是去快速地训练和向公众投放下一个版本。

就像上面提到的实验一样,因为有强大的信息处理和表达能力,GPT-4 可以自己推理和规划,从而设计任务,最后通过调用工具来付诸行动。在 GPT-4 推出后的几周内,让行业最为关注的开源项目就是 AutoGPT 以及类似的 AgentGPT、BabyAGI 等用 GPT-3.5 和 GPT-4 来做推理引擎的智能代理工具。你只需要给 AI 提供一个目标,它们就会将这个目标分解成若干个子任务,再调用外部工具来执行这些子任务,最后来评估任务的执行结果,给出任务的完结报告。我自己就用AutoGPT 来做过几个热门话题的调研工作,得到的结果还不错,不过这一切都是非常早期的试验。但这给出了大语言模型的下一个重要方向,作为智能的中枢来驱动其他软件或者工具自动完成目标与工作,成为人类的智能助理。

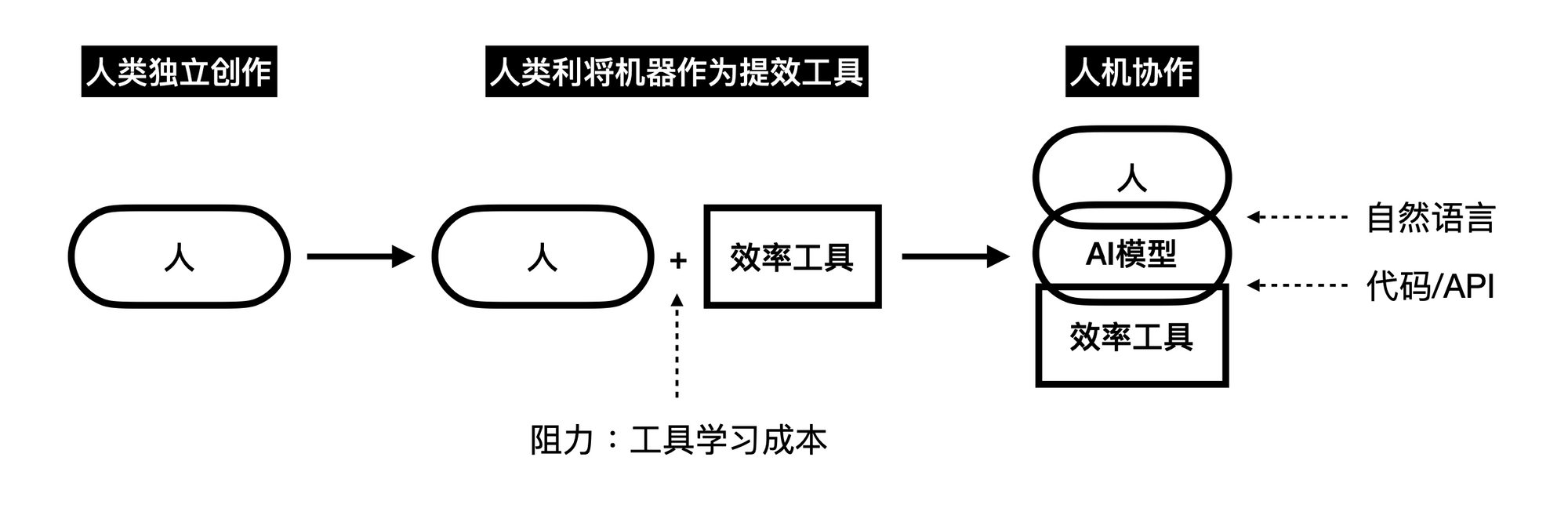

或许 AutoGPT 这种全自动助理的概念过于超前了,而微软即将在 Office 中集成的 Copilot(“副驾驶”)就会是办公场景下的成熟助理,这一方式已经在 Github Copilot 场景下得到了成功应用,利用 GPT-3.5 的代码编写能力可以辅助工程师快速完成编码工作。现在的人机协作,学习如何使用软件,是最大的阻力和成本,但在大语言模型驱动的智能时代,人机协作的关系变成了人类生产者和AI“副驾”的关系。

在这个时代,我们需要保持对创造的热情,这是人与 AI 在动机上最大的差异;我们要提供立意与想法,要有对观察的抽象化能力与对定义的具象化能力;我们要善于叙事和引导,并对 AI 给出的选择做出关键的决策。最重要的一点是,我们要学会深刻理解AI系统的工作方式与它的边界。

人类给 AI 设定目标,AI 来驱动工具,霍夫曼通过他与 GPT-4 的对谈带领我们走向未来。在那里,AI 不再是威胁,而是伙伴,一个可以帮助我们充分发挥作为人类的潜力的伙伴。

GPT-4 翻译 人类监制

感谢湛庐邀请我来做这次新的翻译尝试,我们决定利用 GPT-4 来翻译一本介绍 GPT-4 的书。我想给大家分享一下我的翻译方法:先通过调用 GPT-4 的 API,来实现英文原稿到中文的翻译,然后利用给出提示(Prompt)的方式让 GPT-4 用科技文风重写翻译,这样可以让译文不断接近出版水准。这需要人工在原始译稿阶段对翻译单词和句子的准确性进行校准,毕竟 GPT-4 模型的知识储备还停留在 2021 年底,很多英文内容的中文表述没有与时俱进。

这本书由霍夫曼与 GPT-4 共同撰写,这不仅仅是一本书,更是一场对话,探讨了 AI,尤其是像 GPT-4 这样的大型语言模型,如何在教育、商业和创意等关键领域提升人类的能力。最后,请允许我用霍夫曼的对话风格来结束这篇译者序。

芦义:请解释一下 Impromptu:Amplifying Our Humanity Through AI

GPT-4:Impromptu 是一个通过 AI 提升我们人类特质的概念或倡议。这个倡议旨在促进AI技术的发展,以使其更好地辅助我们的日常生活,同时强调并提升我们作为人类的优点和价值观。

一方面,AI 是对我们自身的延伸,可以帮助我们扩展知识、设计新工具以及解决日益复杂的问题。我们所创造的AI旨在提高生产力、优化资源利用并满足不断变化的需求。

另一方面,Impromptu 还强调我们应当保持人类的核心特质,如创造力、同情心、直觉和道德判断。Impromptu 的目标是利用 AI 来增强这些特质,而不是取而代之,从而使我们能够在这个数字化世界中充满信心地拓展人的潜力。

总之,Impromptu:Amplifying Our Humanity Through AI 强调了AI技术的价值,认为它们应该被用作一种手段来完善我们的人性,并在我们日常生活中找到更好的方向。这也表明,我们应该关注AI技术所带来的机遇,同时关注如何更好地对待彼此,以及我们身边的社会和环境。

---

作为一个 AI 乐观派,我希望人类研究 AI 是为了提高人类智能(Human Intelligence)、人类的潜能和人类的目标感 —— Peace 🌍

2023 年 5 月 6 日

于温哥华完稿

Impromptu 于 2023 年 3 月上市,之后荣登《华尔街日报》畅销书排行榜!这本书的电子版可以免费下载:https://www.impromptubook.com

简体中文版由湛庐文化引进出版,中文名《GPT 时代人类再腾飞》。里德·霍夫曼通过对话的方式与 GPT-4 合著了这本书,这也是一本人人都可以轻松阅读的 GPT-4 科普书,霍夫曼引导式提问技巧很适合学习!本书不仅展示了以 GPT-4 为代表的大语言模型将如何颠覆教育、商业、创造力等诸多领域与行业,如何帮助我们放大人性的特质,释放全部的潜能,同时也对其缺陷和带来的挑战进行了深入的剖析,从中,我们将找到真正的应对之法与破解之道。

未来已来,这将是每一位生活在智能时代的人都要参阅的一部必读之书,是你开启与 Al 共生、协同进化历程的可靠指南与行动路线图。